本文由同步,最新版本请查看原文:

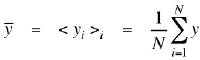

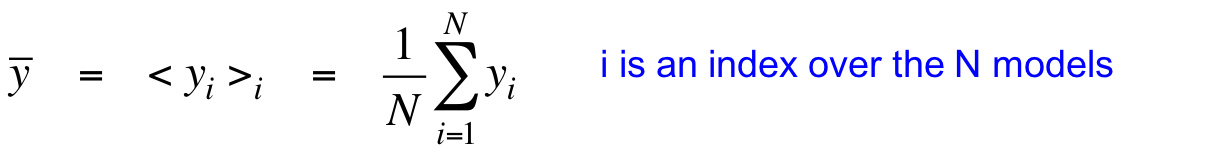

这节课讲了为什么要综合多个模型,好处与原理、具体做法等。讲解了贝叶斯学习中的神经网络模型混合、马尔科夫蒙特卡洛方法,以及从新角度阐释更高效的Dropout。综合网络:偏置方差均衡训练数据少,容易过拟合。综合多个模型可以防止过拟合,特别是当模型做出的预测差别很大的时候。对回归来讲,平方误差可以分解为偏置与方差两项。偏置由模型过于简单带来,方差由模型过于复杂带来。方差项之所以称为方差,是因为再来一个同分布的训练集,因为采样误差的存在,模型拟合的结果会不一样,于是产生方差。通过平均多个模型,可以降低方差。这些被平...

这节课讲了为什么要综合多个模型,好处与原理、具体做法等。讲解了贝叶斯学习中的神经网络模型混合、马尔科夫蒙特卡洛方法,以及从新角度阐释更高效的Dropout。综合网络:偏置方差均衡训练数据少,容易过拟合。综合多个模型可以防止过拟合,特别是当模型做出的预测差别很大的时候。对回归来讲,平方误差可以分解为偏置与方差两项。偏置由模型过于简单带来,方差由模型过于复杂带来。方差项之所以称为方差,是因为再来一个同分布的训练集,因为采样误差的存在,模型拟合的结果会不一样,于是产生方差。通过平均多个模型,可以降低方差。这些被平... 继续阅读: »

原文链接:

感谢阅读本文,欢迎 或访问获取更多内容